В курсе теории вероятностей до сих пор мы находили, в том случае, когда это возможно, вероятности случайных событий. Здесь же мы обратим внимание на неопределенность связанных с этими событиями опытов. Интуитивно ясно, что степень неопределенности (неожиданности) при подбрасывании монеты или игрального кубика различна. Для практики важно уметь численно оценивать степень неопределенности самых разнообразных опытов, чтобы иметь возможность сравнивать их с этой стороны.

Исторически первые шаги к введению понятия энтропии были сделаны в

1928 г. американским инженером-связистом Хартли, предложившим

характеризовать степень неопределенности опыта с ![]() различными

исходами числом log

различными

исходами числом log ![]() . Однако он считал несущественным

возможность неравновероятных исходов. Ошибочность точки зрения

Хартли была показана Клодом Шенноном, предложившим принять в

качестве меры неопределенности опыта

. Однако он считал несущественным

возможность неравновероятных исходов. Ошибочность точки зрения

Хартли была показана Клодом Шенноном, предложившим принять в

качестве меры неопределенности опыта ![]() с возможными

исходами

с возможными

исходами ![]() ,

, ![]() , ...

, ...![]() величину

величину

![\begin{displaymath}

H(\alpha ) = \sum\limits_{i = 1}^k {P(Ai)\log [P(Ai)]^{ - 1}} = -

\sum\limits_{i = 1}^k {P(Ai)\log [P(Ai)]} .

\end{displaymath}](img1079.png)

Он же предложил назвать это число "энтропией".

В применениях энтропии обычно используются логарифмы по основанию два. Это

означает, что за единицу измерения энтропии принимается неопределенность,

содержащаяся в опыте, имеющем два равновероятных исхода. Такая единица

измерения неопределенности называется двойной единицей, или ![]() .

.

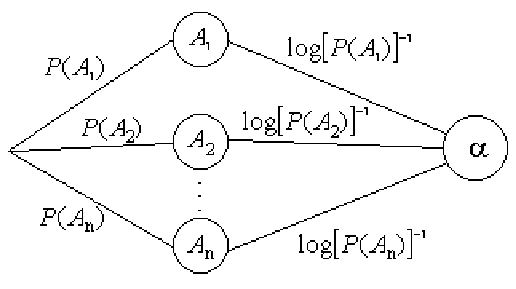

Энтропию дискретного опыта предлагается находить как вес всего графа неопределенности

Реальная ценность понятия энтропии определяется в первую очередь тем, что выражаемая им "степень неопределенности" опытов оказывается во многих случаях именно той характеристикой, которая играет роль в разнообразных процессах, встречающихся в природе и технике и так или иначе связанных с передачей и хранением каких-либо сообщений.

Будущему педагогу понятие энтропии полезно знать, например, для возможного

применения в экспериментальной психологии, одной из основных задач которой

является изучение психологической реакции организма на какое-либо

воздействие. Установлено, что среднее время реакции определяется энтропией

опыта ![]() , состоящего в подаче сигнала.

, состоящего в подаче сигнала.

Пример 111. Какую степень неопределенности содержит опыт извлечения карточки с простой цифрой, вынутой из разрезной цифровой азбуки?

Решение. Из десяти цифр четыре (2, 3, 5, 7) являются простыми, поэтому

вероятность ![]() извлечь карточку с простой цифрой равна 0,4, а

вероятность противоположного события

извлечь карточку с простой цифрой равна 0,4, а

вероятность противоположного события

![]() . Воспользуемся

формулой Шеннона

. Воспользуемся

формулой Шеннона

![]() .

.

Пример 112. Какую степень неопределенности содержит угадывание месяца рождения случайно встреченного человека?

Решение. Поскольку можно считать равновероятным рождение неизвестного человека в любой из 12 месяцев, то воспользуемся формулой Хартли

![]() (бит).

(бит).

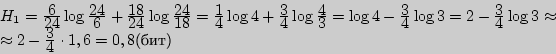

Пример 113. В одной группе 6 студентов из 24 получили в сессию неудовлетворительную оценку, а в другой - 9 из 27. В каком случае сложнее предсказать успеваемость студента?

Решение. Используем формулу Шеннона

![]() >

> ![]() , поэтому сложнее предсказать успеваемость студента во второй

группе.

, поэтому сложнее предсказать успеваемость студента во второй

группе.

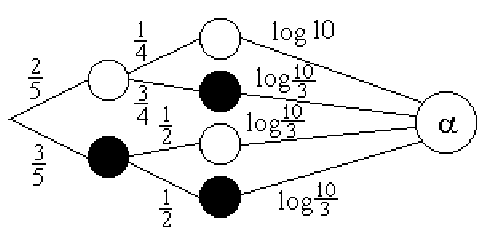

Пример 114. Какую степень неопределенности содержит опыт угадывания цвета двух шаров, извлеченных из урны, в которой находятся два белых и три черных шара?

Решение. Построим граф неопределенности данного опыта.

![]() аходим как вес всего полученного графа.

аходим как вес всего полученного графа.

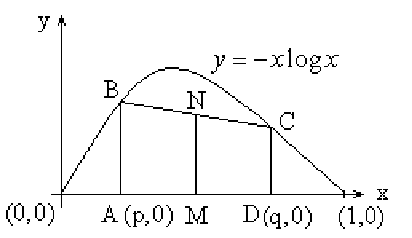

Пример 115. Доказать, что у опытов ![]() с двумя исходами

наибольшую энтропию имеет тот

с двумя исходами

наибольшую энтропию имеет тот ![]() , у которого исходы

равновероятны.

, у которого исходы

равновероятны.

Решение. Построим график функции

![]() (основание у

логарифма больше 1) и рассмотрим среднюю линию

(основание у

логарифма больше 1) и рассмотрим среднюю линию ![]() трапеции

трапеции ![]() , где

, где

![]()

![]() , поскольку функция

, поскольку функция

![]() на промежутке выпукла вверх.

на промежутке выпукла вверх.

Тогда

![]()

Вопросы для самоконтроля

1. Каковы основные требования к функции меры неопределенности?

2. Формула Хартли и ее недостатки.

3. Формула Шеннона.

4. В чем различие формул Хартли и Шеннона?

5. Какие свойства энтропии вы знаете?

6. В каком случае неопределенность опыта наибольшая?

7. Основные единицы измерения энтропии и их связь.

8. Бит и другие его названия.

Задачи

I 221. Какую степень неопределенности содержит угадывание дня рождения случайно встреченного человека?

222. В каком случае менее предсказуем исход: в том, когда подбрасываем монету, или в том, когда угадываем пол первого случайно встреченного человека?

223. Что более непредсказуемо:

а) исход подбрасывания двух игральных костей или

б) угадывание карты из колоды в 36 карт (32 карты)?

224. В одной группе 6 студентов из 20 получили в сессию неудовлетвори-тельные оценки, а в другой - 8 из 24. В каком случае сложнее предсказать успевающего студента?

225. Одна урна содержит один белый и два черных шара, а другая - два белых и три черных. В каком случае угадывание цвета извлеченного из урны шара более предсказуемо?

226. Что более предсказуемо: угадывание масти случайно выбранной кар-ты из колоды в 32 карты или из колоды в 52 карты?

II 227. Какую степень неопределенности содержит опыт извлечения двух карт из колоды в 36 карт относительно козырных карт?

228. Найдите степень неопределенности извлечения двух шаров из урны, содержащей один белый, два черных и три красных шара.

III 229. В первой урне 2 белых и 4 черных шара, а во второй - 3 белых и 3 черных. Из каждой урны вынимают по два шара. Исход какого из этих двух опытов более непредсказуем?

230. В одной подгруппе 3 из 10 студентов получили неудовлетвори-тельную оценку по немецкому языку, а в другой - 4 из 12 по английскому. В каком случае сложнее предсказать успеваемость по иностранному языку двух случайно выбранных студентов одной подгруппы?