Условная энтропия

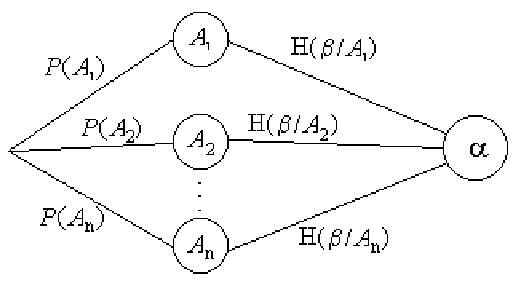

![]() опыта

опыта ![]() относительно исхода

относительно исхода

![]() определяется следующим образом

определяется следующим образом

Условной энтропией

![]() пыта

пыта ![]() относительно

опыта

относительно

опыта ![]() называется математическое ожидание условной энтропии опыта

называется математическое ожидание условной энтропии опыта

![]() относительно всех исходов опыта

относительно всех исходов опыта ![]() :

:

Условную энтропию

![]() предлагается находить по следующему

графу:

предлагается находить по следующему

графу:

Свойства энтропии:

Пример 116. Какую энтропию содержит опыт угадывания простой цифры при извлечении из цифровой азбуки при условии, что одна карточка утеряна?

Решение 1. Пусть опыт ![]() = {утеряна одна карточка} =

= {утеряна одна карточка} =

![]() ,

,![]() , где

, где ![]() ={утеряна карточка с

простой цифрой},

={утеряна карточка с

простой цифрой}, ![]() = {утеряна карточка с непростой

цифрой}. Опыт

= {утеряна карточка с непростой

цифрой}. Опыт ![]() = {угадывание карточки с простой

цифрой}, и в задаче предлагается найти условную энтропию

= {угадывание карточки с простой

цифрой}, и в задаче предлагается найти условную энтропию

![]() .

.

Поскольку карточек с простыми цифрами четыре, то

![]() а

а

![]()

Следовательно,

![]()

=

![]() (бит).

(бит).

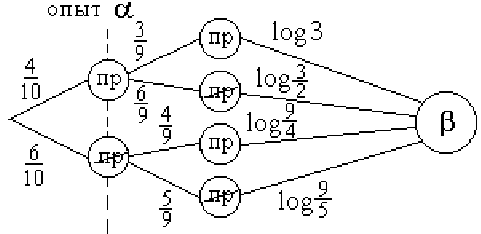

Решение 2. Построим граф двух зависимых опытов ![]() и

и ![]() :

:

Тогда

![]() (бит).

(бит).

Пример 117. Найти энтропию угадывания простых цифр при извлечении двух карточек из цифровой азбуки.

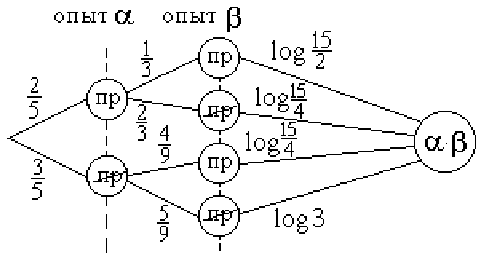

Решение 1. Построим граф неопределенности данного сложного опыта.

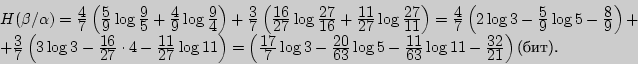

![]() (бит).

(бит).

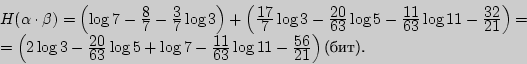

Решение 2. Воспользуемся свойством энтропии, по которому

![]() . Из предыдущего примера

. Из предыдущего примера

![]() , а

, а

![]() Тогда

Тогда

![]() (бит).

(бит).

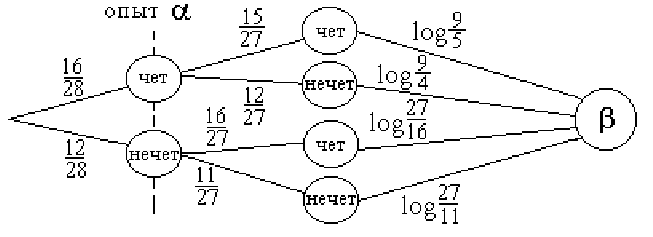

Пример 118. Какую неопределенность содержит опыт угадывания четности суммы очков случайно взятой кости домино, если известно, что одна кость утеряна?

Решение. Утеряна может быть кость с четной суммой или с нечетной, что задает

предварительный опыт ![]() . Находим условную энтропию как полный вес

графа

. Находим условную энтропию как полный вес

графа

Пример 119. Найти энтропию четности сумм очков на двух костях, извлеченных из полного набора домино.

Решение. Пусть опыт ![]() = {извлечение первой кости домино}, а

= {извлечение первой кости домино}, а

![]() = {извлечение второй кости домино}. Тогда энтропию сложного

опыта

= {извлечение второй кости домино}. Тогда энтропию сложного

опыта

![]() находим по правилу сложения энтропий.

находим по правилу сложения энтропий.

![]() ,

где условная энтропия

,

где условная энтропия

![]() вычислена

в решении предыдущего примера.

вычислена

в решении предыдущего примера.

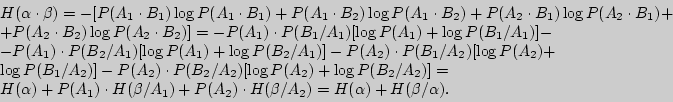

Пример 120. Доказать, что

![]() если опыты

если опыты ![]() и

и ![]() содержат по два исхода.

содержат по два исхода.

Решение. Пусть ![]() = {A

= {A![]() ,A

,A![]() }, a

}, a ![]() =

{B

=

{B![]() ,B

,B![]() }, тогда

}, тогда

![]() ,

,

![]() ,

,

![]() ,

,

![]() } и

} и

Вопросы для самоконтроля

1. Назовите правило сложения энтропий. При каких условиях оно выпол-няется?

2. Как изменяется правило сложения энтропий, если изменить его условия?

3. Как изменяется энтропия опыта, если известен результат одного из его исходов?

4. В каком случае мера неопределенности не изменится при проведении предварительного опыта?

5. Назовите свойства условных энтропий.

6. В каком случае условная энтропия принимает наименьшее значение?

7. Приведите примеры максимальных и минимальных условных энтропий.

Задачи

I 231. Какую степень неопределенности содержит опыт извлечения двух костей домино относительно "дуплей"?

232. Найдите энтропию четности сумм очков на двух костях, извлеченных из полного набора домино.

233. Какую степень неопределенности содержит опыт извлечения двух ша-ров из урны, в которой находятся два белых и три черных шара?

234. На сколько изменится энтропия опыта из предыдущей задачи, если известно, что первым был извлечен белый шар?

235. Найдите энтропию угадывания дней рождения двух случайно встре-ченных людей.

236. Найдите энтропию угадывания месяцев рождения двух незнакомых вам студентов.

II 237. Какую энтропию содержит опыт угадывания простых цифр при изв-лечении из цифровой азбуки двух карточек?

238. Какую энтропию содержит опыт угадывания простых цифр при извле-чении двух карточек из цифровой азбуки при условии, что одна из карточек утеряна?

III 239. Найдите энтропию угадывания простых цифр при извлечении трех карточек из цифровой азбуки.

240. На сколько изменится энтропия опыта из предыдущей задачи, если известно, что первой была извлечена карточка с простой цифрой?