Энтропию цепей Маркова с вектором начальных вероятностей

![]() находим как

математическое ожидание условных энтропий системы

находим как

математическое ожидание условных энтропий системы ![]() относительно

всех ее состояний:

относительно

всех ее состояний:

где

![]()

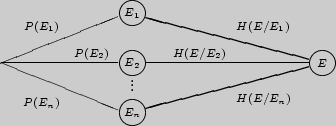

Нахождение энтропии цепи Маркова с вектором начальных вероятностей допускает удобную интерпретацию на графе:

Энтропию цепей Маркова предлагаем находить, суммируя условные

энтропии системы ![]() относительно всех ее состояний.

относительно всех ее состояний.

Пример 126. Найти энтропию цепи Маркова E, заданной матрицей перехода

Решение.

![]() где

где

![]() а

а

![]()

Следовательно,

![]() (бит).

(бит).

Пример 127. На сколько изменится энтропия цепи Маркова из предыдущего примера, если допустить переход за два шага?

Решение. Цепь Маркова ![]() за два шага задается квадратом

матрицы P.

за два шага задается квадратом

матрицы P.

Тогда

![]()

![]() (бит) и

(бит) и

![]() (бит).

(бит).

Таким образом, энтропия возросла на 0,3 бита.

Пример 128. Найти энтропию цепи Маркова, заданной матрицей вероятностей перехода

![\begin{displaymath}

\mbox{\textbf{P}} = \left[ {\begin{array}{l}

0,2 \\

0,5 \...

... \\

{\rm0,2 0,3} \\

{\rm0,1 0,3} \\

\end{array}} \right]

\end{displaymath}](img1174.png)

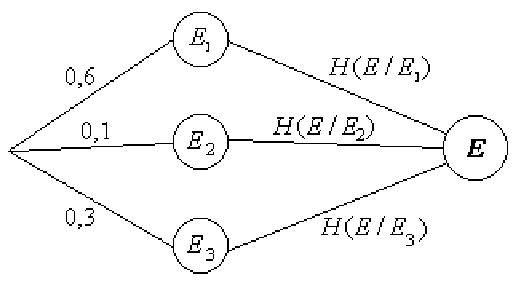

и вектором начальных вероятностей ![]() (0,6; 0,1; 0,3).

(0,6; 0,1; 0,3).

Решение. Находим ![]() как вес графа:

как вес графа:

![]() (бит).

(бит).

Пример 129. Игральная кость под воздействием ветра с вероятностью

![]() остается на месте, с

вероятностью

остается на месте, с

вероятностью

![]() переворачивается на противоположную грань и равновероятно поворачивается

на соседние грани. Найти энтропию данной цепи Маркова.

переворачивается на противоположную грань и равновероятно поворачивается

на соседние грани. Найти энтропию данной цепи Маркова.

Решение. Рассматриваемую цепь Маркова можно задать следующей матрицей перехода:

![\begin{displaymath}

\mbox{\textbf{Р}} = \left[ {\begin{array}{l}

\raise0.5ex\hb...

...m\lower0.25ex\hbox{$\scriptstyle 2$} \\

\end{array}} \right]

\end{displaymath}](img1182.png)

![]() (бит).

(бит).

Пример 130. Найти энтропию цепи Маркова из предыдущего примера, полагая, что в начальный момент времени игральный кубик бросается на ровную поверхность.

Решение. В этом случае имеем цепь Маркова ![]() с вектором начальных

вероятностей

с вектором начальных

вероятностей

![]() и

и

![]() (бит).

(бит).

Вопросы для самоконтроля

1. Что такое энтропия системы относительно одного из ее состояний?

2. В каком случае энтропия системы относительно одного из ее состояний является наибольшей, а в каком - наименьшей?

3. Как определяется энтропия цепей Маркова с вектором начальных вероятностей?

4. Различные подходы к введению энтропии цепей Маркова.

5. В каком случае при увеличении числа состояний системы энтропия не изменяется?

6. Приведите модели цепей Маркова для единицы измерения энтропии.

7. Когда энтропия цепей Маркова принимает наибольшее значение?

8. Приведите примеры цепей Маркова с наибольшими и наименьшими значениями энтропии.

Задачи

I 251. Какую степень неопределенности содержит выбор состояния

![]() в цепи Маркова, заданной матрицей

в цепи Маркова, заданной матрицей

![\begin{displaymath}

{\mbox{\bf Р}} = \left[ {\begin{array}{l}

1 \mathord{\left/...

...n-\nulldelimiterspace} 2 \\

{\rm0} \\

\end{array}} \right]

\end{displaymath}](img1187.png)

252. Дана матрица вероятностей перехода

и вектор начальных вероятностей

![]() Найдите энтропию задан-ной цепи

Маркова.

Найдите энтропию задан-ной цепи

Маркова.

253. Найдите энтропию системы, которая находится в одной из вершин

четырехугольника и переходит в соседние вершины с вероятностью

![]() , а в противоположную - с

вероятностью

, а в противоположную - с

вероятностью

![]() .

.

254. Найдите энтропию системы, заданной матрицей вероятностей пере-хода

![\begin{displaymath}

P = \left[ {\begin{array}{l}

0,2{\rm0,3} \\

{\rm0,1 0,5} ...

...{\rm0,5} \\

{\rm0,4} \\

{\rm0,4} \\

\end{array}} \right]

\end{displaymath}](img1190.png)

и вектором начальных вероятностей

![]()

255. Сравните энтропии цепей Маркова, заданных матрицами вероятнос-тей перехода

![\begin{displaymath}

{\mbox{\bf Р}} = \left[ {\begin{array}{l}

\raise0.5ex\hbox{...

.... {\begin{array}{l}

0 \\

0 \\

1 \\

\end{array}} \right]

\end{displaymath}](img1192.png)

256. Цепь Маркова задана вектором начальных вероятностей ![]() (0,5;0,4;0,1) и матрицей вероятностей перехода

(0,5;0,4;0,1) и матрицей вероятностей перехода

![\begin{displaymath}

P = \left[ {\begin{array}{l}

0{\rm0,2} \\

{\rm0,6 0,3} \\...

...\rm0,8} \\

{\rm0,1} \\

{\rm0,5} \\

\end{array}} \right].

\end{displaymath}](img1194.png)

Найдите энтропию заданной цепи Маркова.

II 257. Даны вектор начальных вероятностей

![]() и

переходные вероятности

и

переходные вероятности

![]() (

(![]() =1, 2, 3). Найдите энтропию цепи Маркова

за два шага.

=1, 2, 3). Найдите энтропию цепи Маркова

за два шага.

258. Рассмотрим марковскую цепь с двумя состояниями ![]() и

и ![]() и

матрицей вероятностей перехода

и

матрицей вероятностей перехода

Найдите энтропию цепи Маркова за три шага.

III 259. В двух отделениях ящика находятся три шара. Каждую минуту случайным образом выбирается отделение и из него перекладывается в другое отделение один шар. Найдите энтропию марковской цепи, рассмат-ривающей в качестве состояний число шаров в первом отделении.

260. По двум урнам разложено N черных и N белых шаров так, что каждая урна содержит N шаров. Число белых шаров в первой урне определяет состояние системы. В каждый момент времени выбирают случайно по одному шару из урны и выбранные шары меняют местами. Найдите энтропию заданной цепи Маркова.